Des satellites aux téléphones portables, l’intelligence artificielle a investi nos objets techniques au point de devenir un compagnon du quotidien. Elle partage nos vies, mais pour quelles conséquences ? Comprendre et anticiper les mutations portées par l’IA est devenu un enjeu majeur et urgent, dont la société tout entière doit se saisir.

Par Ludovic Viévard, rédacteur.

>> Version à feuilleter en ligne : cliquez ici

>> Ou téléchargez le pdf du Pop’Sciences Mag #15 :

Qu’elle soit réellement intelligente ou qu’elle en simule les effets, l’IA n’est plus une promesse, mais une réalité. En quelques années seulement, elle s’est répandue dans une multitude d’applications, à l’impact quotidien, y compris pour le grand public. Or, le développement de ce puissant outil n’est pas sans conséquences, même s’il est parfois difficile d’en lire les effets secondaires, ceux qui nous reconfigurent en profondeur. Alors que nous fait l’IA ? Quels effets a-t-elle sur nos façons d’être humain et de faire société ? Quelles réflexions devons- nous conduire pour en conserver la maîtrise et limiter les risques ?

Vers l’infini et au-delà !

La promesse de l’IA est immense et ses bénéfices sont déjà tangibles. Fondateur, le mythe de Babel explique comment la démesure des hommes, engagés dans la construction d’une tour dont le sommet toucherait le ciel, leur a valu pour punition divine de ne plus se comprendre entre eux. Mais l’IA générative pourrait bien mettre un terme à cette malédiction empêchant la communication. Deep-L, Chat GPT, Google Translate… ces applications effritent la barrière des langues. Hibiki, l’IA développée en France par Kyutai, un laboratoire de Xavier Niel, permet même une traduction vocalisée simultanée !

Autre exemple, dans le champ de la santé, où l’IA se rend progressivement indispensable, pour la gestion des flux de patients, l’analyse de leur dossier, la personnalisation des soins, et même le diagnostic[1] . Une étude sur le, dépistage du cancer[2] du sein montre qu’elle améliore la lecture des mammographies et, ainsi le taux de détection du cancer qui passe, de 0,70 % à 0,82 % et réduit les taux de faux, positifs de 2,39 % à 1,63 % ! Langues, santé, mais aussi finance, transports, logistique, énergie, e-commerce, culture… les IA sont, partout, avec des gains de temps et d’efficacité importants.

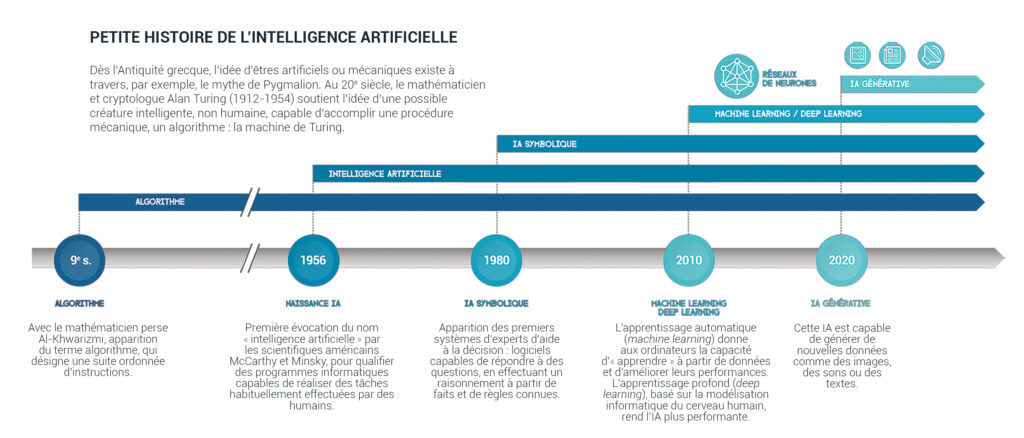

Pour une visibilité optimale de la frise, faites « clic gauche » pour ouvrir l’image dans un nouvel onglet.

Des outils qui nous contraignent

Ces algorithmes qui nous secondent dans notre vie quotidienne ne sont, cependant, pas sans conséquences, variables selon les IA et leurs applications. L’une d’elles, prévient Mathieu Guillermin, docteur en physique et philosophie, enseignant-chercheur à l’Institut catholique de Lyon, c’est l’effet de sidération que peuvent produire les algorithmes de recommandation. Cet effet nous rend passifs, comme captifs de contenus qu’une IA sélectionne en fonction de ce qu’elle connaît de nous (amis, précédentes lectures ou achats, etc.). Il peut renforcer nos paresses intellectuelles et favoriser la propagation de fausses informations (fake news). « L’efficacité des algorithmes de recommandation des réseaux sociaux menace notre capacité à disposer d’un fond d’informations commun à partir duquel nous projeter dans une dimension politique, précise le chercheur. C’est plus pernicieux que le mensonge car, contrairement au mensonge, il s’agit de dire que le vrai n’a pas de valeur. »

Ce brouillage entre vrai et vraisemblable est d’autant plus fort que les IA fonctionnent à partir de jeux de données dont la constitution peut contenir des biais. Des algorithmes ont déjà produit des résultats sexistes ou racistes, comme l’explique Sara Bouchenak, professeure d’informatique à l’INSA Lyon et chercheure au Liris, dans The Conversation[3]. À propos d’une IA de recrutement d’une grande entreprise de logistique, elle précise : « parce que les femmes travaillant dans [ce] secteur sont statistiquement peu nombreuses, l’IA qui en résulte rejette tout simplement les candidatures féminines ». Et d’en appeler à un travail rigoureux, pour éviter ces biais dans la constitution des données, voire d’en tenir compte afin de corriger les déséquilibres sociaux. Ces efforts pour une IA éthique sont au cœur du projet de recherche consacré aux données de santé, ANR CITADEL[4], coordonné par Sara Bouchenak, ou du cluster AILyS[5], porté par Aurélien Garivier, professeur de mathématiques à l’École normale supérieure de Lyon.

Vers un effritement de l’empathie ?

Si l’IA est un puissant outil pour l’analyse des données de santé, « le soin est fait d’une relation qui ne se laisse pas réduire à de l’information brute », prévient Jean-Philippe Pierron, professeur de philosophie à l’Université de Bourgogne et co-directeur de la chaire « Valeurs du soin » de l’Université Jean Moulin Lyon 3. Or, médecins et infirmiers voient leur métier évoluer vers des tâches consistant à renseigner les données de santé des patients pour qu’elles soient traitées par des algorithmes qui, en retour, fourniront diagnostics et prescriptions personnalisées. « Attention à ne pas transformer les soignants en « travailleurs du clic », dont le temps consacré à nourrir les données des IA sera pris sur celui de la relation au malade ». Car ces outils ont tendance à survaloriser l’analytique au détriment des dimensions affective, interprétative et incarnée de l’intelligence humaine. D’un côté « la vigilance, une forme caricaturée de l’attention que l’IA traite parfaitement à partir des data », et de l’autre, « l’attention qui se définit par la disponibilité à l’autre et la qualité de la présence à l’autre ». Tout l’enjeu sera alors d’articuler ces deux « régimes de présence, un travail éthique et politique de balance à faire entre l’un et l’autre », conclut Jean-Philippe Pierron.

Car la place de l’IA n’est que celle que nous lui donnons. Aujourd’hui, elle dépend de choix industriels, économiques et politiques. Or, ces choix interrogent la société en profondeur, raison pour laquelle c’est tout le corps social qui est appelé à se prononcer.

Organiser la réflexion collective

On le voit, il y a un réel enjeu à discuter des impacts de l’IA, qu’ils soient individuels ou sociétaux. Sommes-nous, par exemple, prêts à accepter un désapprentissage, ou deskilling ? Dans un texte de 2022[6], Wendy Mackay, qui dirige le groupe de recherche en interaction humain-machine à l’Inria de Paris-Saclay, définissait ce deskilling, comme « le processus par lequel les compétences d’un humain sont rendues désuètes, voire perdues, lorsqu’un élément de technologie peut accomplir la tâche pour lui ». Pourquoi apprendre une langue, à rédiger un résumé ou même à lire, si des IA peuvent le faire pour nous ? Quel sens redonner à nos apprentissages ? Penser les IA, c’est penser notre condition humaine.

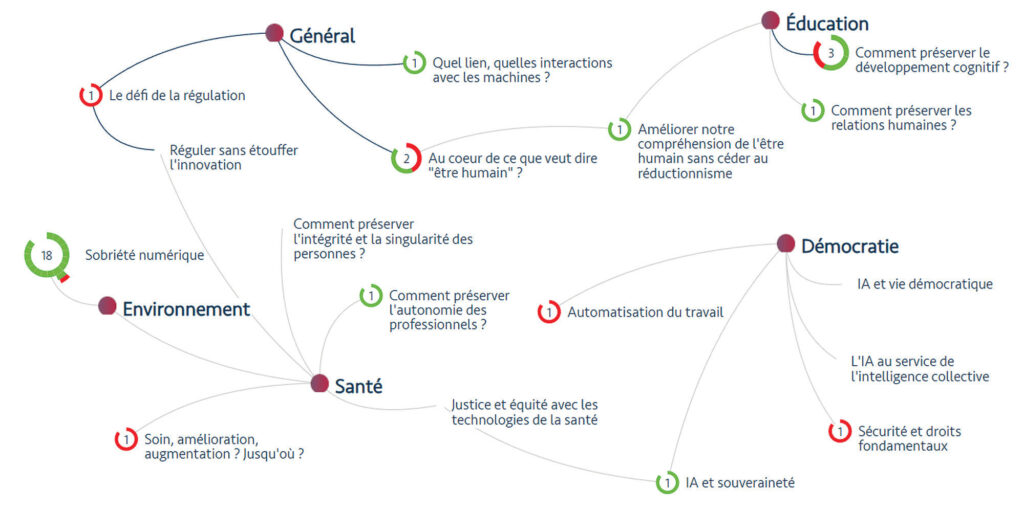

Pour Mathieu Guillermin, « les bouleversements technologiques sont une chance de remettre l’accent sur les questions de fond. Par exemple, l’apparition de Chat GPT interroge tout le monde sur le « Pourquoi j’écris », et par extension, le « Pourquoi j’apprends ». Pour les étudiants notamment, il existe aujourd’hui une vraie possibilité de déléguer de nombreux travaux à l’IA et d’obtenir sans effort un résultat convaincant ». Que veut dire être humain au temps de l’IA et des neurosciences ? C’est l’interrogation qui est au cœur du projet de recherche qu’il coordonne : un Nouvel Humanisme au temps des Neurosciences et de l’Intelligence Artificielle (NHNAI). Alimenté par une expertise académique pluridisciplinaire et internationale, NHNAI structure, dans 9 pays, des échanges ouverts à tous, en présentiel et via « CartoDÉBAT ». Cette plateforme en ligne permet d’organiser une réflexion citoyenne collective pour interpeler le politique. C’est, en effet, à lui de légiférer pour borner le souhaitable dans l’immense champ des possibles ouverts par l’IA et de limiter les appétits privés et industriels.

Et demain ?

Ce qu’accomplissent les IA est chaque jour plus impressionnant. Des chercheurs lyonnais, dont Matteo di Volo, professeur junior de neurosciences à l’Université Claude Bernard Lyon 1, travaillent sur des réseaux de neurones artificiels plus proches de notre propre cerveau. L’objectif ? « Une IA biologique plus puissante et plus fonctionnelle », explique-t-il dans Cortex Mag[7].

Déjà, les IA agents se multiplient. Bien qu’encore limitées, ces IA promettent d’exécuter des tâches concrètes pour notre compte, comme rédiger et envoyer un mail, réserver un billet de train, etc. Une action spécifique, certes, mais désormais effective dans le monde physique. Le pas d’après ? L’IA générale (IAG), capable de réaliser, elle, l’ensemble des tâches intellectuelles que nous pouvons accomplir, et sur lesquelles planchent les grandes entreprises de la tech. Quand ces outils arriveront à maturité, ils transformeront d’autant encore les relations homme – IA et, par extension, ce que nous sommes et nos organisations sociales.

S’il est si important d’en avoir conscience c’est que, prévient Aurélien Garivier, « le risque est que l’écart s’amplifie entre les gens qui maîtrisent ces technologies et conservent un regard critique et les utilisateurs qui ont encore moins besoin qu’avant d’apprendre ce que réalisent ces outils et en deviennent dépendants ».

Notes

[1] État des lieux de l’intelligence artificielle (IA) en santé en France, Ministère de la Santé (2025).

[2] Andreas, D., et al., Early Indicators of the Impact of Using AI in Mammography Screening for Breast Cancer, Radiology, 311 : 3 (2024).

[3] Bouchenak, S., Apprendre à plusieurs endroits en même temps pour ne pas révéler ses secrets : vers une IA plus vertueuse, The Conversation (2024).

[4] Confidentialité et mitigation du biais dans l’apprentissage fédéré pour la santé numérique, projet mené par LIRIS, LIFO, HCL et MEERSENS.

[5] Porté par l’ENS de Lyon, le cluster AILyS regroupe une quinzaine d’établissements de recherche et d’enseignement supérieur du site de Lyon et Saint-Étienne et une trentaine d’entreprises pour former un pôle d’excellence européen sur l’IA.

[6] Rowe-Pirra, W., Repenser l’interaction entre l’humain et la machine, Collège de France (2022).

[7] Depecker, C., Synchronisation et chaos : deux qualités de notre cerveau inégalées par l’IA, Cortex Mag (2024).

CartoDÉBAT : outiller le dialogue citoyen

En 2023, le projet NHNAI propose une des enjeux sociétaux de l’IA – fruit d’ateliers en présentiel. Cette représentation des thèmes centraux (démocratie, environnement, santé, éducation…) et leur connexion est alors soumise à un débat en ligne. Mais l’originalité de CartoDÉBAT est de structurer les échanges en utilisant : « oui mais », « oui et », « pas compris ». Ainsi se construit progressivement une réflexion réellement collaborative, large et approfondie sur les enjeux éthiques de l’IA

De quelle IA avons-nous besoin ?

Ce qu’on appelle l’IA, est-ce vraiment de l’intelligence ? Jusqu’où ses capacités peuvent-elles la mener ? Qu’a-t-elle changé dans notre façon de penser, décider, agir, créer ? Que faire, au niveau individuel comme collectif, pour garder la maîtrise ?

Découvrez les réponses de Mathieu Guillermin, philosophe des sciences à l’Institut catholique de Lyon, et Aurélien Garivier, mathématicien à l’École normale supérieur de Lyon.

POUR ALLER PLUS LOIN

- L’IA, une intelligence sans esprit, par Ludovic Viévard, Pop’Sciences Mag #15, été 2025.

- IA et créativité : une (presque) interview de Flavien Chervet, par Ludovic Viévard, Pop’Sciences Mag #15, été 2025.

- Comment l’intelligence artificielle va changer nos vies, CNRS Le Journal (2018).

- Nowakowski, S., L’essentiel de l’intelligence artificielle, Studyrama (2024).

- Cappé, O., Marc, C., Tout comprendre (ou presque) sur l’intelligence artificielle, CNRS Éditions (2025).

- Comment l’IA redéfinit notre compréhension du monde, France Culture (2025).