Pour son premier numéro, Pop’Sciences Mag interroge une révolution technologique fascinante autant que bouleversante. L’effervescence médiatique pour le sujet est un indicateur du besoin d’information sur l’intelligence artificielle (IA). Profitant qu’à Lyon nous disposons d’un riche vivier d’innovation et de recherche scientifique, nous avons pris le sujet à bras le corps et rencontré les meilleurs experts. Ce premier numéro souhaite offrir des clés de compréhension et nous éclairer sur ce qu’est réellement l’IA, sur ceux qui l’imaginent et sur ce à quoi elles sont destinées.

Par Samuel Belaud

Photographies : Visée.A

Téléchargez le Pop’Sciences Mag en .pdf

Téléchargez le Pop’Sciences Mag en .pdf

L’intelligence artificielle se définit comme la création de machines capables de résoudre des problèmes et de prendre des décisions qui nécessitent habituellement une intelligence humaine pour être accomplies. Par de complexes algorithmes, il s’agit d’imiter ou de remplacer l’humain dans certaines de ses fonctions cognitives, en assimilant ou en générant des quantités quasi-infinies de données symboliques (lettres, mots, dessins, photographies, raisonnements, etc.) ; et en faisant des choix en fonction de celles-ci.

Les prémices de cette grande discipline scientifique s’opèrent dès les années 50, a posteriori des travaux fondateurs d’Alan Turing. Depuis, les ingénieurs, développeurs et chercheurs n’ont eu de cesse de s’inscrire dans une impressionnante course à l’innovation, aujourd’hui en pleine pointe de vitesse. Les programmes se sont améliorés au point, désormais, de créer des représentations complexes de la connaissance, de démontrer des théorèmes, de générer du langage, de reconnaître des formes subtiles, ou encore de battre les meilleurs joueurs de jeux stratégiques comme le Go.

Nous sommes à un jet de pierre d’achever la conception de la « bibliothèque universelle »

Demain nous aurons créé sur Terre une machine capable de lire, comprendre et catégoriser tout ce qu’Homo Sapiens a écrit depuis qu’il existe. Des premiers glyphes rupestres aux grands classiques de la Renaissance, en passant par nos commentaires sur des forums ou l’intégralité des manuels de montages de meubles. Pour autant, peut-on en conclure que les machines sont à « deux doigts » d’être cognitivement plus puissantes que les humains ? Pas si simple. Il nous faut désormais nous interroger sur ce que promettent les IA et identifier les risques sous-jacents à leurs développements. De cette manière, nous aurons les moyens de déployer des agents technologiques raisonnables et compatibles à l’Homme.

S’informer et réfléchir aux réalités de l’IA dans nos sociétés, aux innovations disponibles et aux choix que nous voulons faire

Qui pour nous rassurer sur le fait que les objectifs induits dans les algorithmes sont en adéquation avec les valeurs de leurs utilisateurs ? Quel degré d’autonomie accorder aux IA sans que celles-ci ne reproduisent des effets discriminatoires ou d’exclusion ? Comment ne pas pousser à l’extrême le profilage des individus, et induire par là une société déconnectée de logiques collectives et démocratiques ? La science-fiction nous alerte depuis déjà longtemps sur les dérives potentielles liées à la « mal-programmation » de nos technologies. Et pourtant, il nous est permis de rêver et de croire en la complémentarité de l’Homme avec l’intelligence artificielle.

Une opportunité pour activer de nouvelles utopies

Les concepts fondateurs mathématiques et informatiques de l’IA sont autant de révolutions intellectuelles que d’opportunités pour l’Homme de réinventer ses modes de vie. Afin de mieux participer à la durabilité de son espèce et de son environnement.

Nos chercheurs, nos experts, ainsi que nous citoyens, avons tous un rôle à jouer dans cette « réinvention » d’une intelligence artificielle compatible à l’Homme, en nous imposant un cadre éthique et juridique efficace. Mais également en agissant pour une meilleure diffusion des savoirs, davantage de débats et une recherche qui questionne sans cesse ses finalités aux regards d’objectifs citoyens et durables.

Pop’Sciences Mag propose un tour d’horizon de programmes scientifiques lyonnais emblématiques en IA. Une plongée au cœur de cette effervescence créatrice, des craintes et des espoirs qu’elle suscite.

PHILOSOPHIE

“Méfions-nous du mythe de Prométhée !”

C’est la mise en garde que lance Mathieu Guillermin, philosophe, spécialiste des enjeux éthiques liés aux nouvelles technologies. Selon lui, le recours aux mythes pour éclairer les enjeux que soulève l’IA nous pousse à surinterpréter ce phénomène. Il alimente les peurs et les fantasmes ; il nous détourne d’une réflexion collective sur sa « souhaitabilité ». Au risque d’entraîner un rejet irrationnel du progrès technologique.

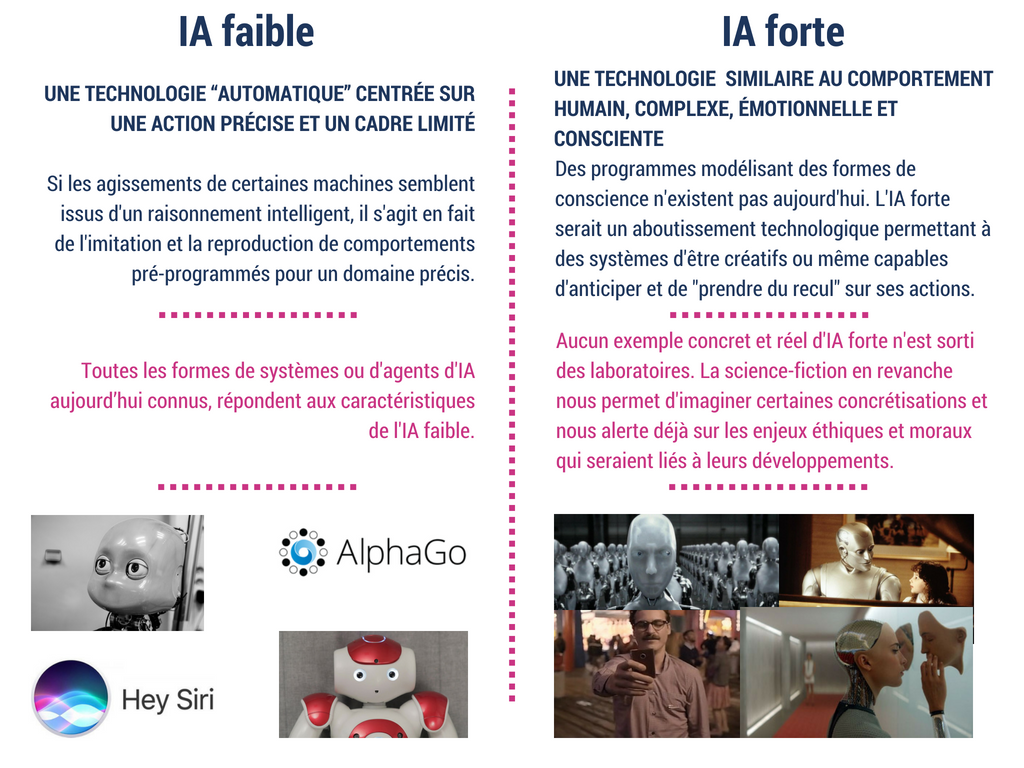

La première fois que le philosophe a entendu parler d’intelligence artificielle remonte à ses jeunes années, lorsque abreuvé de science-fiction, il a découvert une forme de nouvelle technologie qui serait douée de subjectivité et de sentiments. Les romans, les films et les BD faisaient intervenir l’IA comme une entité à part entière, douée de conscience, similaire à celle des humains. Le doute était jeté sur l’imminence d’un passage d’une IA faible à une IA forte.

@Université de Lyon

À ce propos, ce que le test de Turing propose comme principe de distinction entre les deux formes d’IA est intéressant. Dans son ouvrage Computing Machinery and Intelligence, Alan Turing pose un jeu (imitation game) : un interrogateur est censé, par un principe de questions/réponses, déterminer si celui qui lui répond (et qu’il ne voit pas) est un humain ou une machine. À des échelles significatives d’expérience, encore aucune machine n’a aujourd’hui réussi à « passer » ce test et à semer le doute sur sa faculté à penser par elle-même.

Mathieu Guillermin juge que nous sommes très loin de l’élaboration d’une machine capable de passer le test de Turing. Néanmoins, si une machine se hissait un jour à ce niveau, « là nous serions face à des questions fondamentales et complexes » telles que : peut-on l’éteindre ? Est-elle une entité morale ? Il apprécie également ce que « l’humble définition » de Marvin Minsky (pionnier de l’IA, spécialiste de psychologie cognitive, réseaux neuronaux et mathématicien) dit de l’intelligence artificielle. Pour ce dernier, « il y a de l’intelligence artificielle lorsqu’on fait faire par une machine des tâches qui auraient nécessité une forme d’intelligence si elles avaient été effectuées par un humain ».

Le chercheur nous a délivré une analyse insoupçonnée et captivante sur les développements en cours de l’IA et leurs probables répercussions sur nos modes de vie et nos rapports aux autres. Selon lui, l’intelligence artificielle surpasse les enjeux éthiques qui ont été soulevés au fur et à mesure des anciennes révolutions technologiques (roue, écriture, imprimerie, chemin de fer, électricité …). Il nous surprend en nous invitant – cette fois-ci – à nous méfier des mythes fondateurs.

Interview

Comment la mythologie peut-elle nous permettre de mieux appréhender cette révolution technologique ?

Parler de révolution technologique, c’est utiliser exactement le bon terme. Les avancées récentes dans le domaine de l’intelligence artificielle reflètent davantage un bouleversement technologique que théorique. Au vu de l’explosion de données en circulation, combinée à l’augmentation de la puissance de calcul de nos machines (les phénomènes de Big Data), nous sommes effectivement face à une révolution sans précédent pour nos modes de vies. En revanche, tous les mythes qui nous expliquent que par la technique l’Homme se dote de la puissance des dieux (lire l’encadré sur le mythe de Prométhée), poussent tout un chacun à surinterpréter les révolutions technologiques et c’est particulièrement vrai pour l’intelligence artificielle.

Le mythe de Prométhée évoque l’acte indocile du frère d’Épiméthée pour dérober le feu aux dieux de l’Olympe, afin de le donner aux hommes. Cet acte leur permet de s’élever et de se doter de « techniques » permettant leur subsistance. (Jean-Simon BERTHELEMY © Musée du Louvre).

L’espoir de nous approcher des dieux n’est pas un arrière-plan des plus adéquats pour aborder cette révolution technologique et ses enjeux éthiques.

Je préférerais que nous tentions de mieux nous comprendre et nous épanouir à travers cette révolution. Méfions-nous donc de Prométhée et du mythe qui lui est associé, tant il permet trop de jouer sur les peurs et d’alimenter les fantasmes.

La mythologie et les conceptions des premiers philosophes construisent nos arrière-plans de pensée. Ce que Platon nous a délivré en particulier n’est guère plus rassurant que le mythe de Prométhée dans l’interprétation de l’IA. Pour résumer, Platon place la logique, le logos, au fondement du monde ; à partir de ce postulat, nous avons, notamment en France, des représentations collectives très marquées où nous plaçons la mathématique comme « supérieure » à d’autres disciplines. Qu’est-ce qui pourrait alors empêcher qui que ce soit de penser que l’IA est forcément acceptable, objective et non-opposable, sous prétexte qu’elle est composée par du code et donc basée sur des racines mathématiques ?

Au cas où ces mythes se prolongent et que nous dotions des machines d’un certain « degré de conscience »… devrons-nous aller jusqu’à infliger une part de responsabilité aux IA pour leurs actes préjudiciables ?

Nous n’y sommes pas encore. Selon moi, la loi de Moore plafonne et il ne paraît vraiment pas évident que la courbe de l’innovation se poursuive au même rythme.

La loi de Moore est ici entendue dans un sens commun. Cette règle est dérivée des deux premières lois de Moore (1965 et 1979) qui stipulent que le nombre de transistors sur un microprocesseur double à peu près tous les deux ans. Plus généralement, elle décrit la courbe exponentielle de la puissance et des capacités de nos systèmes de calculs et illustrent l’explosion technologique des 70 dernières années.

Malgré tout, nous allons rapidement être confrontés à de sérieux dilemmes éthiques. La voiture autonome en est un exemple significatif. On nous promet des véhicules autonomes et intelligents sur nos routes d’ici 20 ans, mais ce type de mobilité génère des dilemmes éthiques dont les alternatives sont toutes « éthiquement inacceptables » ; par exemple, lors d’un accident inévitable, faut-il sacrifier les occupants du véhicule ou les passants ? La majorité de mes étudiants sont très frappés par la véritable difficulté à faire des choix dans ces cas, voire par le simple fait de poser la question et de devoir faire un choix. Leur réaction est très juste à mon sens. Cette répulsion à faire un choix dans ce type d’alternative montre selon moi que nous sommes déjà allés trop loin, et me semble être une raison suffisante de ne pas créer d’autonomie à 100% pour ces véhicules. Demandons-nous d’abord s’il est souhaitable de faire face à de tels choix, avant de nous demander à qui incombera la responsabilité d’un événement préjudiciable.

Visée.A

D’autant plus que nous n’arrivons pas à résoudre clairement cette question de la responsabilité. Derrière un algorithme d’intelligence artificielle, des milliers de lignes de codes, éditées par des centaines de codeurs depuis plusieurs années, sont présentes. C’est un détail qui a son importance dans la question de la « dilution de la responsabilité ».

➠ Plus loin dans le Mag : Transports : « Œuvrer à une meilleure coopération homme-machine ».

Ce qui va changer avec les agents intelligents et autonomes, c’est que la prise de décision sera tellement distribuée qu’il me paraît trop facile et très illusoire de masquer tout ceci en attribuant une responsabilité à l’IA. Cela risque évidemment d’entraîner des dérives, mais je crois que les grands principes fondamentaux du droit français sont déjà très bons guides pour poser des garde-fous et inventer de nouvelles formes de régulation adéquates.

Les structurations inconscientes de nos sociétés occidentales posent comme principe la propriété d’un véhicule personnel et je pense que le moment est venu de réinterroger nos modes de mobilité. Sommes-nous à ce point utilitaristes que nous en venons à l’idée de trancher ces dilemmes éthiques (« qui tuer entre la vieille femme et le petit chien !? ») avant de réfléchir à nos modes de vie ?

➠ Sur le portail Pop’Sciences : Les robots anthropomorphiques, entre mythes et réalités : Inéluctables, inquiétants, nécessaires ?

Dès lors, Rabelais disait-il vrai en considérant que « la science sans conscience n’est que ruine de l’âme » ?

L’analyse de Gilbert Simondon, philosophe du 20e siècle, sur l’inertie des systèmes techniques* est intéressante pour observer que c’est au fur et à mesure que les possibilités techniques apparaissent que nous pensons leur souhaitabilité et leur légitimité. L’évolution des technologies qui transforment nos sociétés est ainsi largement dominée par une sorte de passivité face aux développements techniques. Changer l’ordre des choses serait selon moi fondamental, car nous avons déjà observé qu’à ne pas encourager en amont des réflexions (éthiques) collectives, nous générons ou contribuons à des rejets ultérieurs de certains pans techniques (les OGM, par exemple). Des rejets indiscriminés et massifs qui expriment plus de peur et de colère que de rationalité collective.

En 1958, Gilbert Simondon explique, dans son ouvrage Du mode d’existence des objets techniques, que la technique est essentiellement liée à l’expérience de l’échec de nos agissements.

Un enjeu majeur pour nous chercheurs et développeurs techniques est donc de savoir comment dire nos découvertes, comment être honnête sur leur portée et comment débattre de leur intérêt sociétal. Par exemple, concédons qu’il ne soit pas impossible de créer une IA forte, ayant du nez, de l’instinct, une capacité informelle, s’adaptant au contexte et consciente … Pourrions-nous réellement nous permettre d’en entamer l’élaboration pour autant ? Il faudrait par exemple prendre sérieusement en compte la question environnementale ! L’énergie nécessaire à l’entraînement et au fonctionnement des IA est très importante. L’approvisionnement en métaux (semi-)conducteurs essentiels à leur construction est délicat (gisements avec concentration suffisante peu nombreux et en épuisement rapide), etc. Nous sommes de facto contraints par notre système et cela va dans le même sens que le plafonnement que j’évoquais à propos de la loi de Moore.

Alors allons-nous devoir nous résigner à nous projeter dans des paradis artificiels ?

Pour moi il faut porter une attention particulière au risque de perte de sens et de rapport au réel.

Récemment, Thomas Samuel Kuhn, philosophe et historien des sciences, expliquait que le monde dans lequel nous vivons dépend des concepts à travers lesquels nous le pensons. Il pose en fait la question de savoir si nous sommes bien conscients de la réalité, ou bien si nous n’en percevons que des simulacres. Même si selon moi cette intuition est philosophiquement intéressante, je ne crois pas qu’il faille nous pousser à décrédibiliser le réel et à amoindrir l’expérience que nous nous faisons du monde. De mon point de vue, un entre-deux est à rechercher entre la raison pure d’Emmanuel Kant (notre connaissance ne saurait dépasser les limites de l’expérience) et l’interprétation très ontologique de T.S. Kuhn.

C’est une bonne chose que nous ayons pris de la distance avec l’idée d’un unique réel fondamental (par exemple un logos singulier). Mais le risque est que cela puisse encourager chacun à se croire libre d’interpréter le monde à sa manière, à assumer sa vérité et à se noyer dans un paradis artificiel.

En dépit de ces potentielles dérives, les applications de réalité virtuelle peuvent être source d’optimisme et je tiens à insister là-dessus. Il faut simplement faire attention à ne pas se perdre dans cet artifice, ne pas oublier qu’il s’agit d’illusions ou de rêves… Cette précaution prise, rien ne s’oppose à ce que la réalité virtuelle se révèle extrêmement utile et positive. On peut imaginer son apport dans le cas d’une thérapie post-traumatique, par exemple. Elle pourrait aussi être un formidable moyen de démultiplier les capacités créatives.

LE MYTHE DU ROI MIDAS

La légende raconte que Dyonisos accorda à ce roi la faculté de transformer en or tout ce qu’il touchait. Midas fut piégé par son propre voeu cupide, incapable de manger les denrées qu’il avait saisies, ou d’étreindre ses proches sans que ceux-ci ne se métamorphosent en statues dorée.

L’Homme a cette propension à formuler des désirs incompatibles avec sa propre nature. Ce mythe résonne comme une mise en garde … Pour faire en sorte que les objectifs induits dans des machines n’aillent jamais à l’encontre de la liberté et de l’intégrité physique de leurs utilisateurs.

- Direction de la Publication : Khaled Bouabdallah, Président de l'Université de Lyon

- Rédaction en chef : Florence Belaën, Directrice culture, sciences et société - Université de Lyon

- Auteurs : Samuel Belaud (Université de Lyon ) ; Benoît de La Fonchais (Oxymore Conseil)

- Direction artistique : Antoine Ligier (Visée.A)

- Comité de rédaction : Patricia Lamy, Samuel Belaud, Marine Bourdry (Université de Lyon ) ; Antoine Ligier (Visée.A) ; Benoît de La Fonchais (Oxymore Conseil)

- Crédits illustrations : Julien Richetti ; Solène Rebière

- Crédits photographiques et vidéos : Visée.A

- Partenaires scientifiques et universitaires : Hoomano ; Institut Cellule souche et cerveau (Inserm, Université Claude Bernard Lyon1, Inra) ; Groupe d'Épistémologie et d’éthique des sciences et des technologies du laboratoire de Biologie générale de l’Institut catholique de Lyon (UCLy) ; Centre régional de lutte contre le cancer Léon Bérard ; Institut français des sciences et technologies des transports, de l’aménagement et des réseaux (IFSTTAR) ; Laboratoire Ergonomie et sciences cognitives pour les transports (LESCOT) ; Transpolis ; Chaire de recherche « Talents de la transformation digitale » à Grenoble École de Management ; Lyon-IsAI ; CPE Lyon - École supérieure de chimie, physique, électronique de Lyon.

- Partenaires institutionnels : Région Auvergne-Rhône-Alpes ; Métropole de Lyon ; Ville de Villeurbanne.